Integración de IA

El Microservicio de Integración de IA ofrece una solución centralizada para conectar agentes de IA en el metaverso con proveedores como OpenAI y Azure AI.

Para crear un agente potenciado por IA en XR Creator Studio, deberás conectar un modelo de IA compatible (de OpenAI o Azure) configurando la clave API, el ID del asistente o el endpoint.

¿Qué es un Agente de IA?

Un Agente de IA es una entidad digital configurable impulsada por un modelo de lenguaje (como OpenAI o Azure AI) que puede interactuar con los usuarios en entornos inmersivos como el metaverso. Sus componentes principales incluyen:

- Modelo: El motor de IA subyacente (por ejemplo, GPT-4, GPT-3.5) que genera las respuestas.

- Memoria: Determina si el agente conserva el historial de conversación temporalmente (volátil) o entre sesiones (persistente).

- Instrucciones de interacción: Indicaciones del sistema que definen la personalidad, el rol y las restricciones del agente, como “Eres un asistente útil especializado en productos de la empresa”.

Ejemplos de Agentes de IA

XR Creator Studio admite tres tipos distintos de Agentes de IA, cada uno integrado mediante un método diferente y con capacidades únicas:

-

Agente de Finalización de Azure AI

Se conecta mediante un endpoint y una clave API. Ofrece opciones de voz, detección de proximidad y activadores de eventos. -

Agente de Finalización de OpenAI

Utiliza la API de OpenAI y el nombre del modelo. Admite memoria volátil o persistente, síntesis de voz y eventos mediante scripts. -

Agente Asistente de OpenAI

Construido con la API de Assistant de OpenAI. Permite subir archivos y utilizar herramientas, lo que facilita una comprensión contextual más profunda y memoria a largo plazo.

Uso de Finalización vs Asistente

La elección entre ellos depende de las necesidades de tu proyecto: si prefieres interacciones rápidas y ligeras o un asistente más robusto y consciente del contexto.

-

Agentes basados en Finalización

Se basan en interacciones de tipo pregunta-respuesta. Proporcionas una indicación del sistema y el modelo genera respuestas. Son ideales para agentes ligeros y reactivos con memoria opcional. -

Agentes basados en Asistente

Utilizan la API de Assistant de OpenAI y admiten funciones avanzadas como búsqueda de archivos, memoria persistente e integración de herramientas. Son más adecuados para tareas complejas que requieren continuidad y contexto profundo.

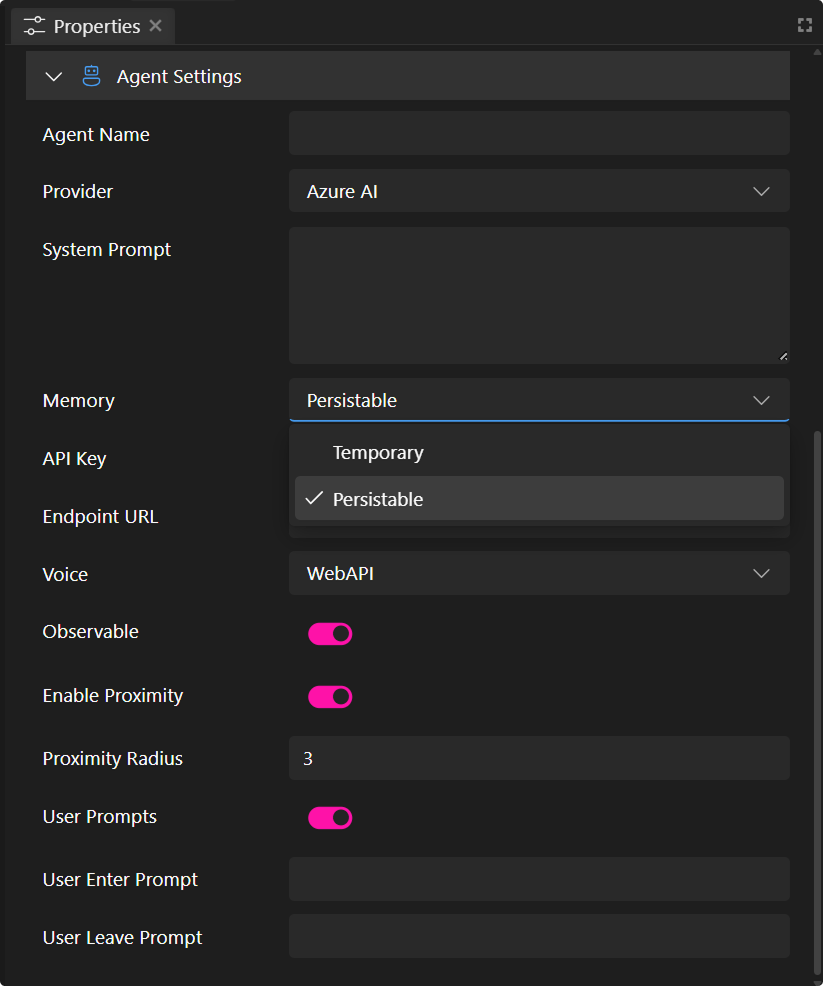

Crear un Agente de IA con Azure AI Completion

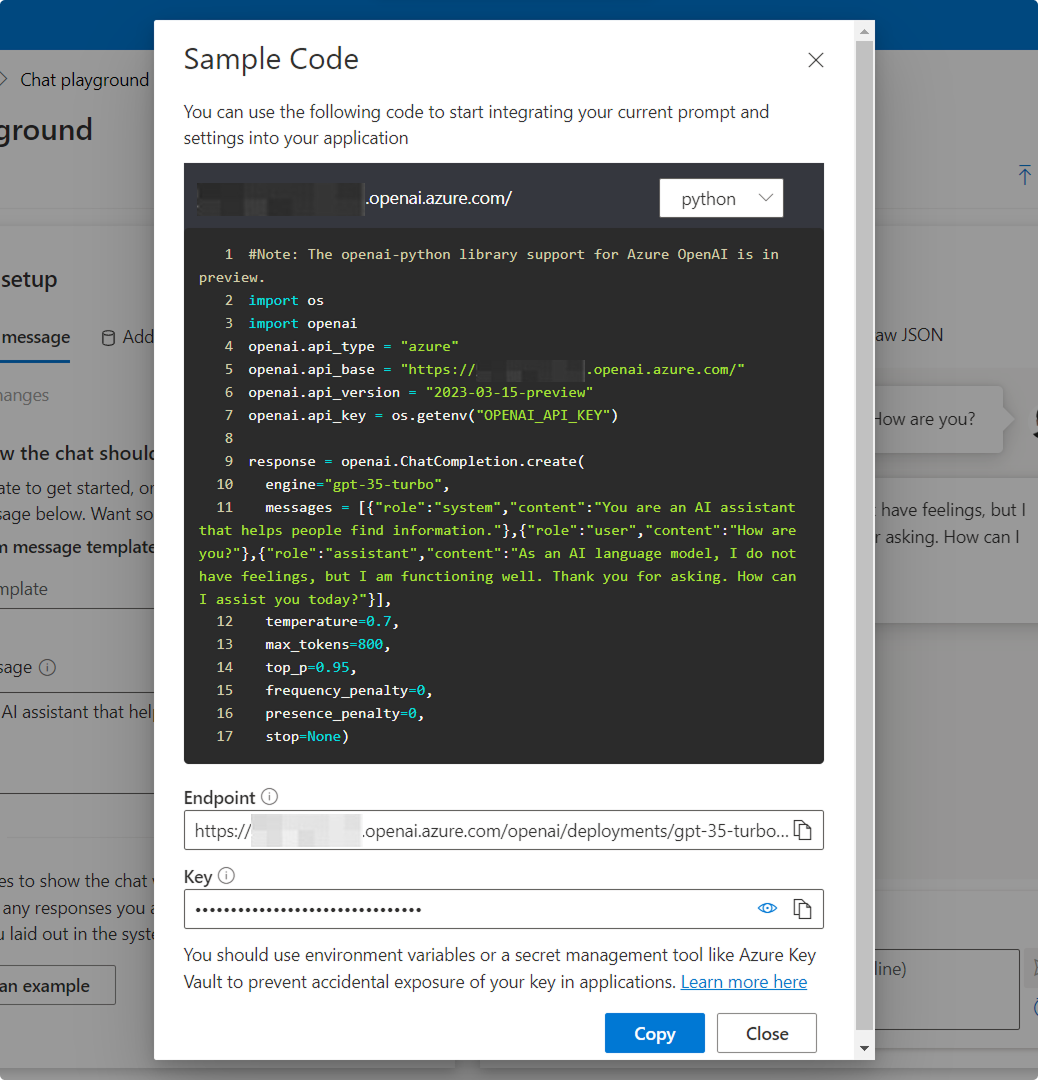

Paso 1: Encuentra la Clave API y el Endpoint en Azure OpenAI Playground

- Visita: https://oai.azure.com/portal (O entra al portal de Azure, navega hasta tu recurso de OpenAI y haz clic en "Playground" en la barra lateral.)

Paso 2: Abre la Configuración del Playground

- En la esquina superior derecha del Playground, haz clic en el botón "View Code".

- Esto abrirá un panel que muestra cómo llamar al modelo actual mediante la API.

Paso 3: Obtén tu Endpoint y Clave API

El campo Endpoint y Key representa los tokens secretos utilizados para autenticar tus solicitudes API al servicio Azure OpenAI.

-

En el panel View Code, localiza la URL del endpoint y la clave:

-

Endpoint: La URL completa que tu aplicación utiliza para enviar solicitudes (incluye el nombre del deployment y la versión de la API).

-

Key: Una clave API sensible utilizada para autorizar dichas solicitudes.

-

Ejemplo de uso del Endpoint (para Completions)

Reemplaza <your-resource-name> y <deployment-id> con tus valores reales en el siguiente formato:

https://<your-resource-name>.openai.azure.com/openai/deployments/<deployment-id>/completions?api-version=2023-05-15

Paso 4: Encuentra el Nombre del Deployment

- En la parte superior del Playground, revisa el desplegable Model.

- El valor seleccionado es tu Deployment ID (por ejemplo,

gpt-35-turbo). - Este debe coincidir con el nombre del deployment usado en la URL del endpoint.

Paso 5: Integra tu Agente de Azure AI con XR Creator Studio

Una vez que hayas configurado un asistente en Azure AI, puedes integrarlo en tu proyecto XR.

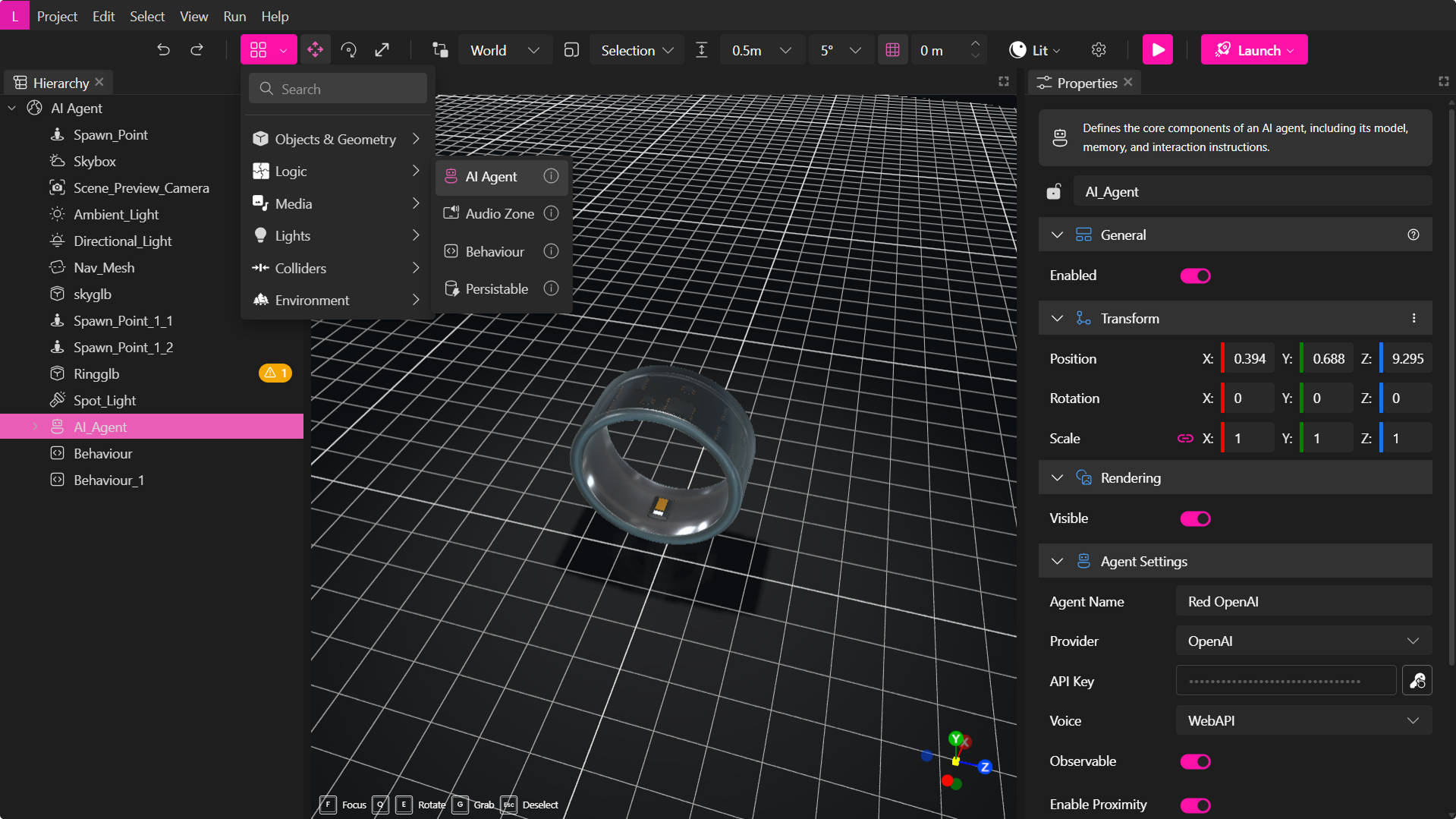

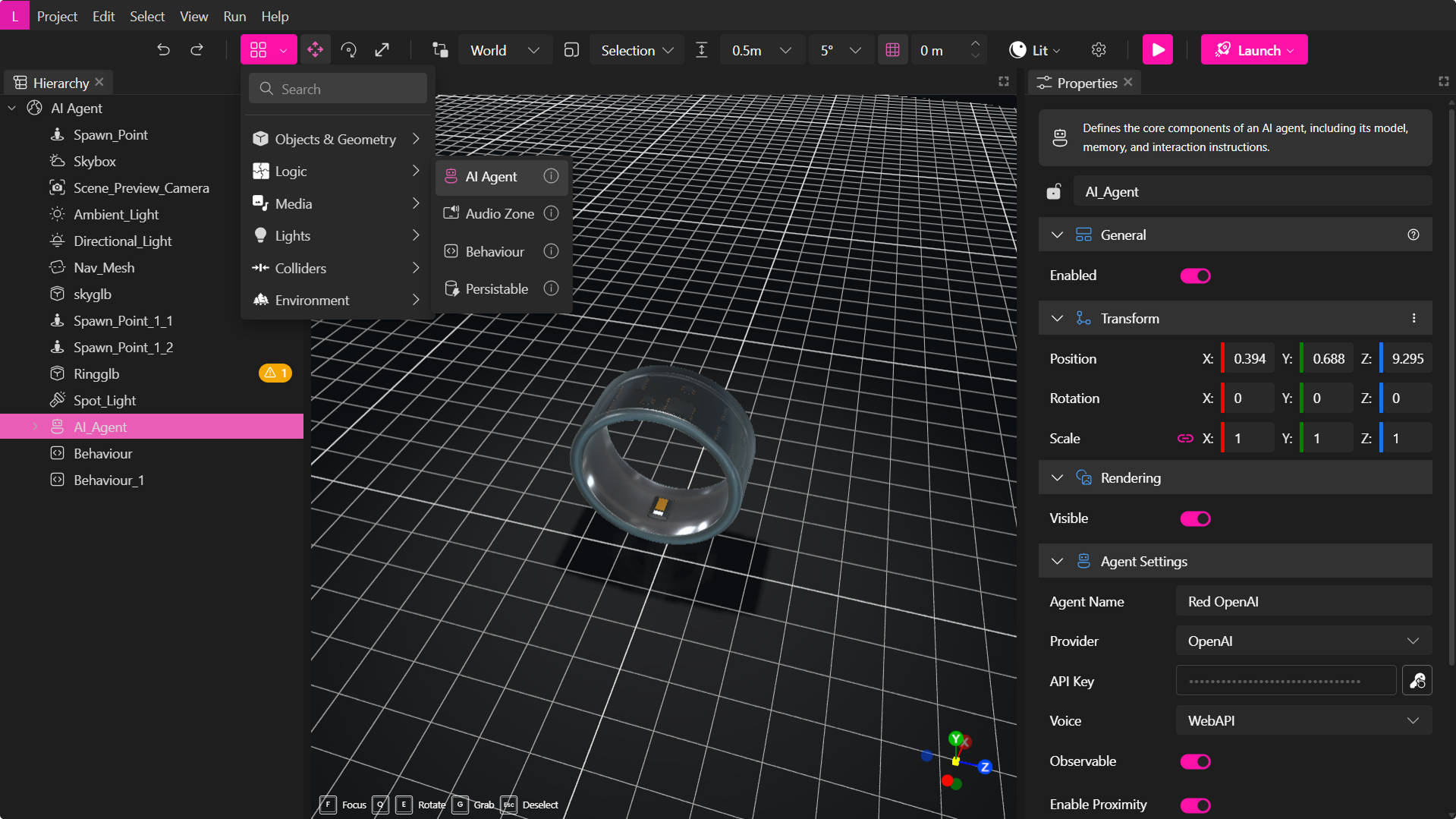

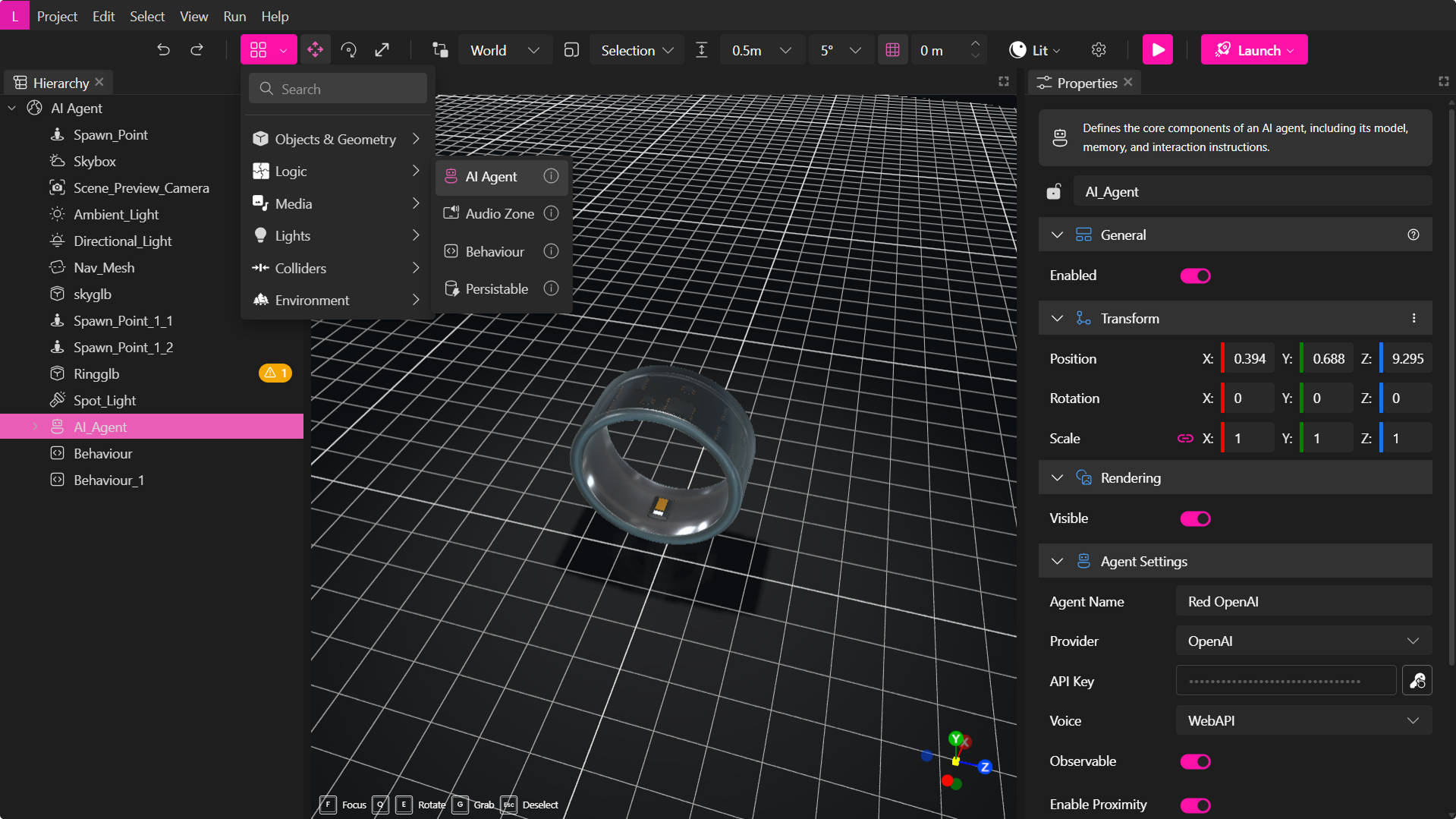

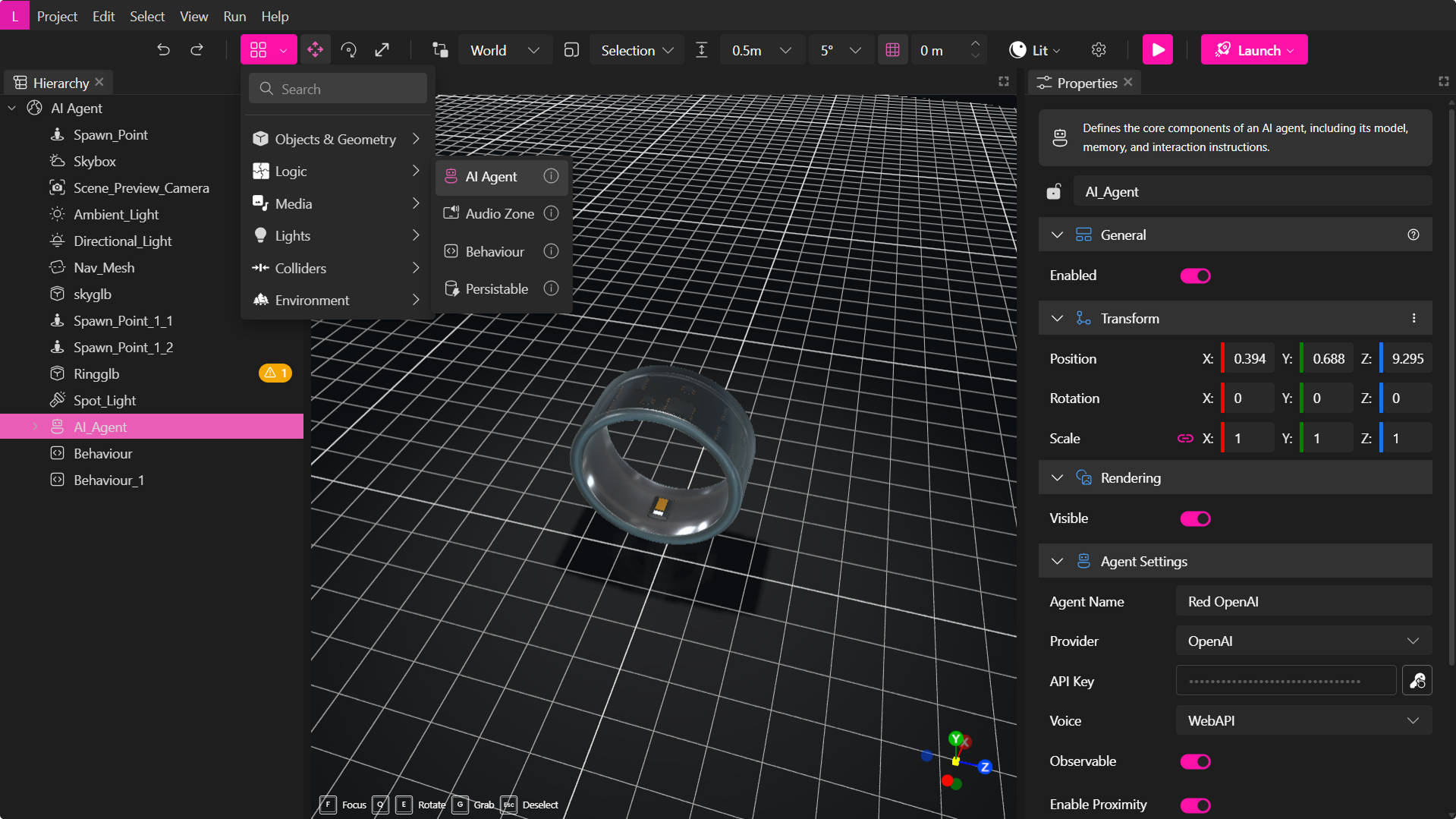

1. Agrega un Elemento de Agente de IA en XR Creator

- Abre tu proyecto en el Editor XR.

- En el Menú de Elementos, selecciona AI Agent.

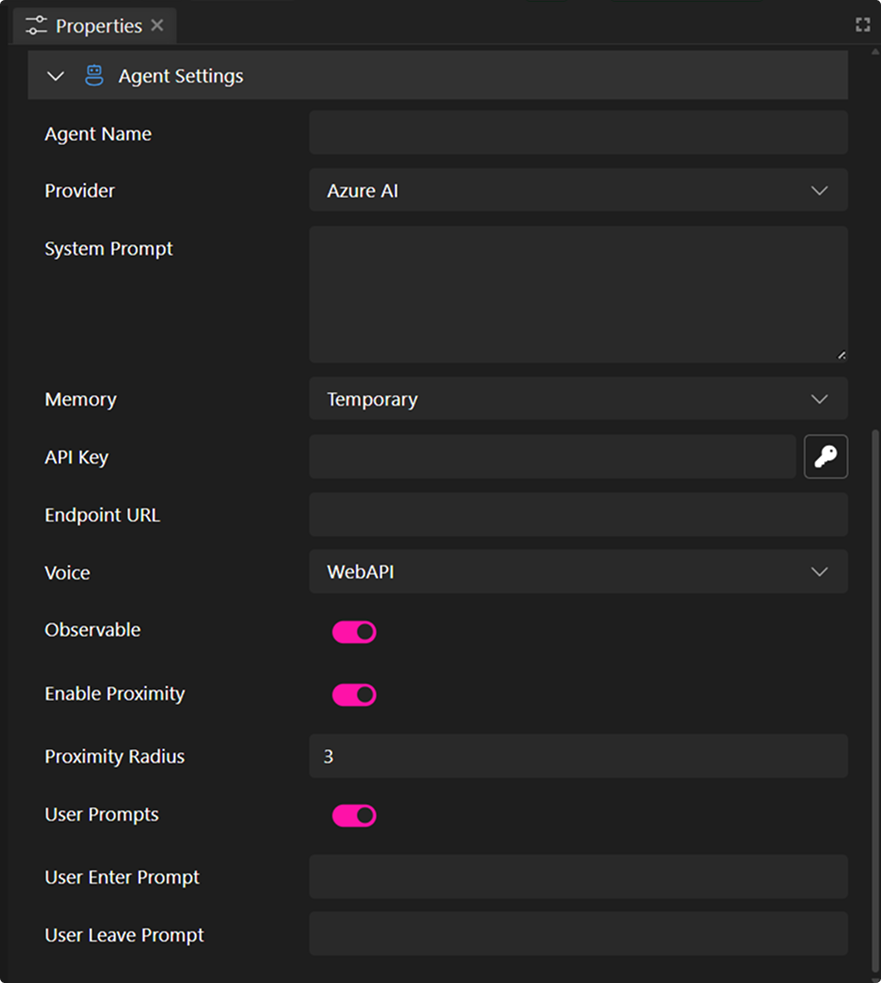

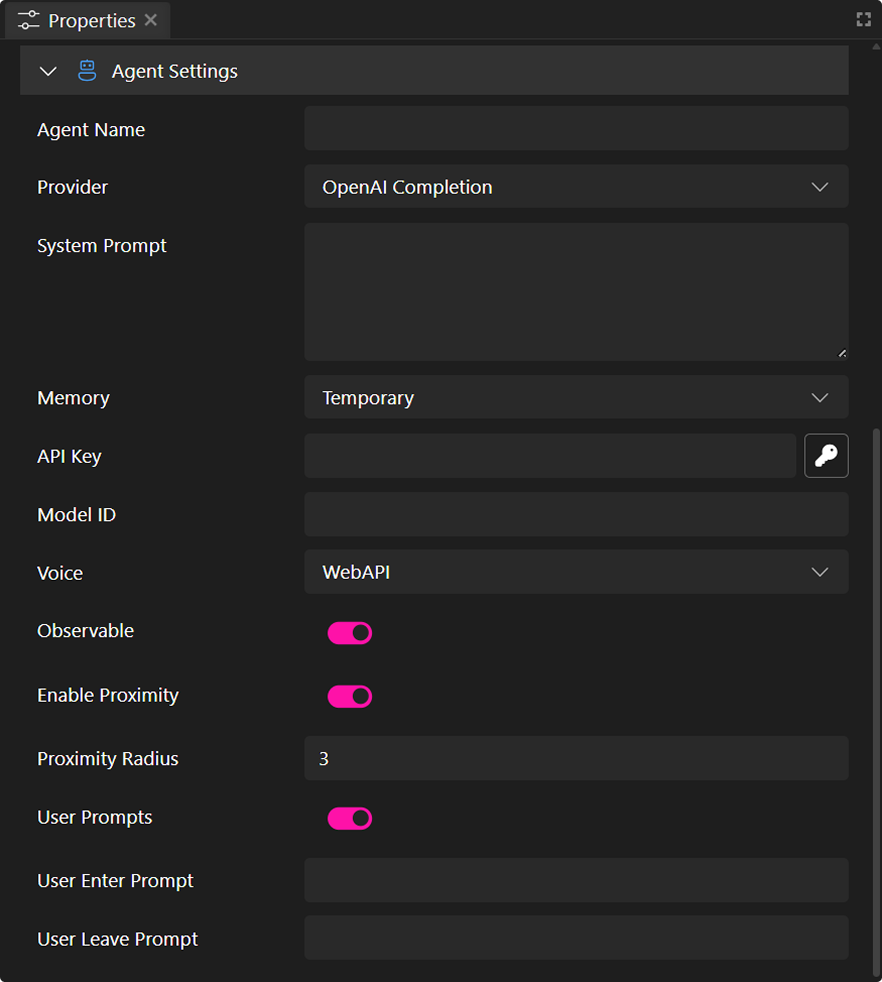

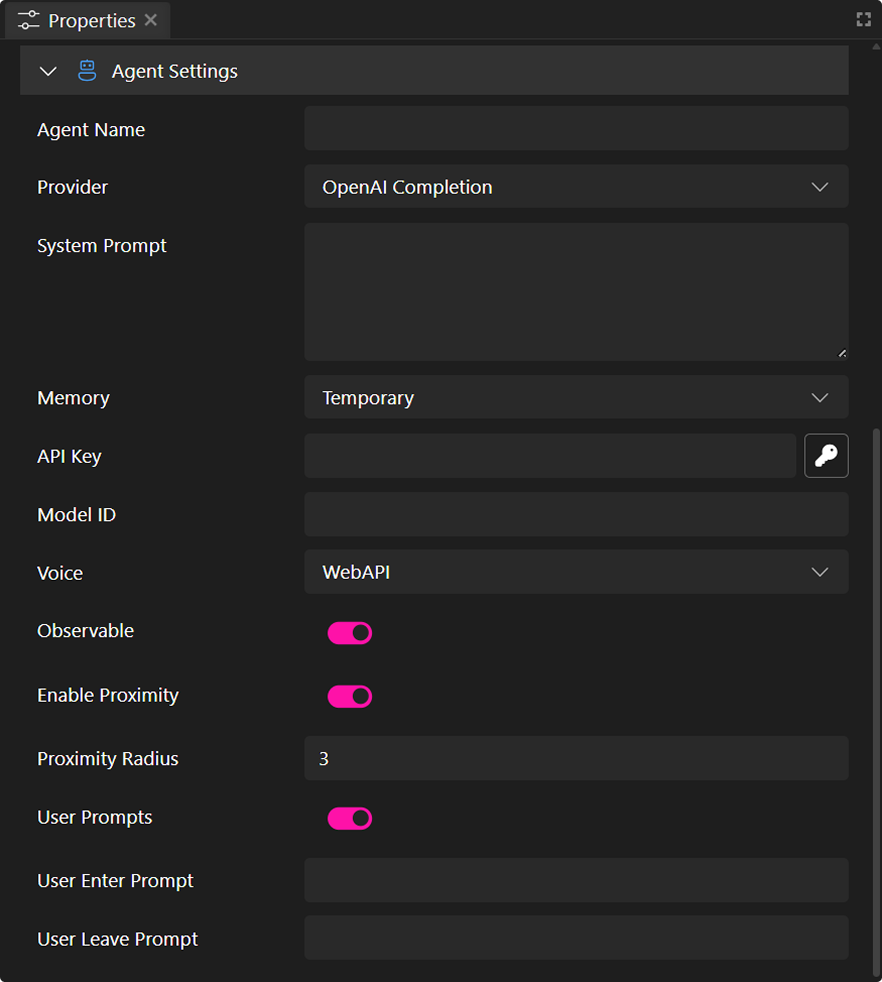

2. Configura las Propiedades del Agente de IA para Conectarse a Azure AI

En el Panel de Propiedades, puedes establecer parámetros para conectar tu agente de IA.

- Nombre del Agente: Este nombre aparecerá en la interfaz de chat.

- Proveedor: Selecciona el servicio de IA. En este caso, selecciona la opción Azure AI Completion.

- System Prompt: Instrucciones que definen el rol, personalidad o restricciones de la IA (por ejemplo, "Eres un asistente útil especializado en productos de la empresa."). Longitud máxima ~4000 caracteres. Este campo es opcional.

- Clave API: Ingresa tu clave API secreta de forma segura.

- Endpoint: (Requerido para el proveedor Azure AI) La URL del endpoint específica para tu deployment en Azure OpenAI. La puedes encontrar en el Playground.

- Opciones de Voz:

- WebAPI – Utiliza texto a voz basado en navegador (varía según el navegador).

- Silent – El agente solo se comunicará vía chat de texto.

- Observable (Emitir Eventos): Activa esta opción para lanzar eventos de scripting en el mundo. Especialmente útil con nuestra API de Scripting. Más detalles en la Guía del sistema de eventos del agente de IA.

- Activar Proximidad: El agente puede detectar cuando un usuario entra o sale de un rango definido.

- Radio de Proximidad: Establece la distancia (en metros/unidades) alrededor del agente donde se activan eventos de proximidad.

- Mensajes de Usuario: Activa esta opción para mostrar mensajes personalizados cuando los usuarios entren o salgan del área de proximidad.

- Mensaje al Entrar: Mensaje que el agente dirá o mostrará al entrar en el radio.

- Mensaje al Salir: Mensaje que el agente dirá o mostrará al salir del radio.

- Mensajes de Usuario: Activa esta opción para mostrar mensajes personalizados cuando los usuarios entren o salgan del área de proximidad.

- Radio de Proximidad: Establece la distancia (en metros/unidades) alrededor del agente donde se activan eventos de proximidad.

Solo la clave API y el endpoint son obligatorios. Una vez que configures estas propiedades, podrás publicar tu proyecto y tener un agente completamente funcional.

Crear un Agente de IA con OpenAI Completion

Sigue estos pasos para configurar un Agente con OpenAI Completion.

Paso 1: Crea una Cuenta en OpenAI

- Visita la Página de Registro de OpenAI y crea una cuenta.

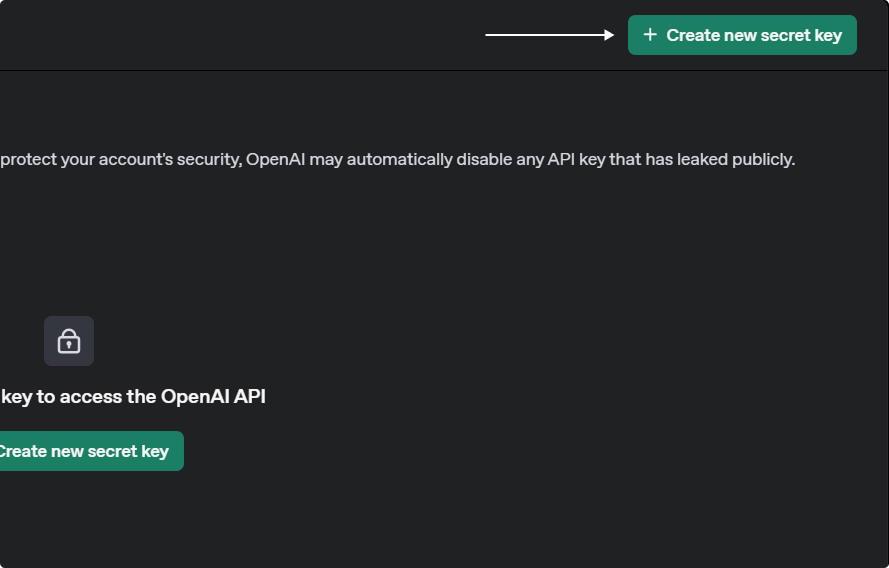

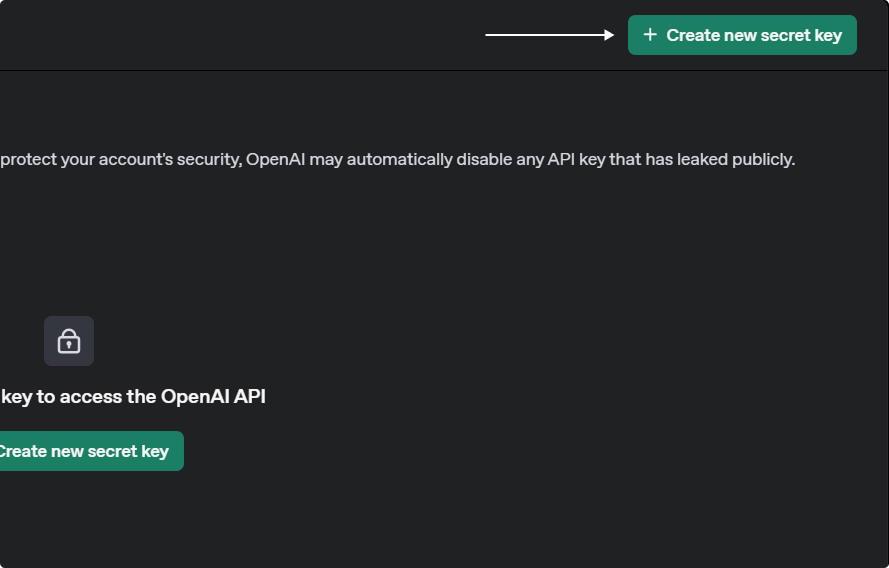

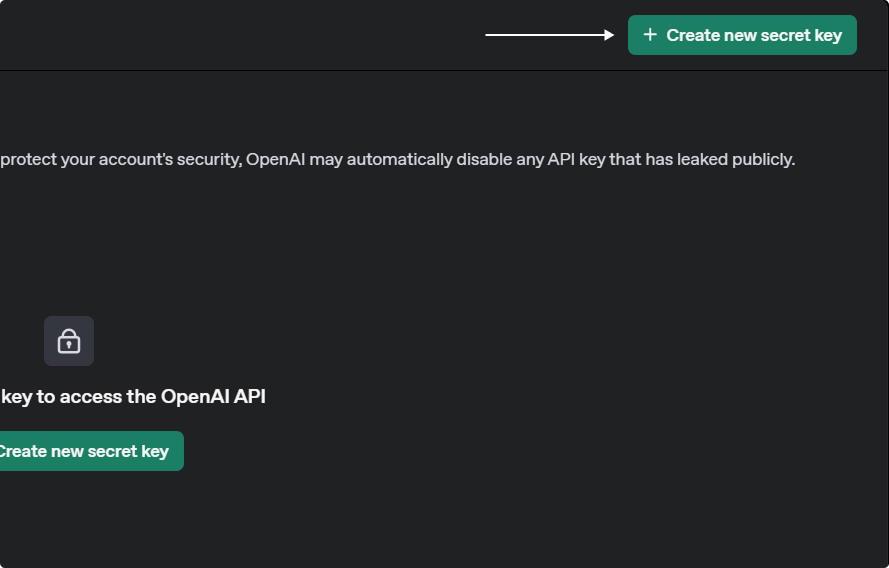

Paso 2: Genera una Clave API de OpenAI

- Ve al Panel de OpenAI.

- Navega a la Sección de Claves API.

- Haz clic en Crear nueva clave secreta.

- Proporciona un nombre, selecciona un proyecto y establece permisos de seguridad.

- Copia y guarda tu clave API de forma segura, ya que no se mostrará de nuevo.

Una vez configurado tu asistente de OpenAI, puedes integrarlo en tu proyecto XR.

Paso 3: Integra tu Agente OpenAI con XR Creator Studio

1. Agrega un Elemento de Agente de IA en XR Creator

- Abre tu proyecto en el Editor XR.

- En el Menú de Elementos, selecciona AI Agent.

2. Configura las Propiedades del Agente de IA

En el Panel de Propiedades, puedes establecer los parámetros para conectar tu asistente.

- Nombre del Agente: Este nombre aparecerá en la interfaz de chat.

- Proveedor: Selecciona el servicio de IA, en este caso, OpenAI Completion.

- System Prompt: Instrucciones que definen el rol, personalidad o restricciones de la IA (por ejemplo, "Eres un asistente útil especializado en productos de la empresa."). Máximo ~4000 caracteres. Campo opcional.

- Memory: Define el tipo de memoria que puede utilizar tu agente de finalización. Por defecto, funciona con memoria volátil temporal, lo que significa que el agente conservará el historial del chat solo durante tu sesión. Una vez que salgas, la memoria se borrará. Alternativamente, puedes habilitar la memoria persistente, permitiendo que el agente mantenga el historial del chat a lo largo de varias sesiones.

- Clave API: Ingresa tu clave API secreta de forma segura.

- Nombre del Modelo: (Requerido para OpenAI Completion) El modelo específico de OpenAI a utilizar (por ejemplo, gpt-3.5-turbo, gpt-4, etc).

- Opciones de Voz:

- OpenAI – Usa generación de voz de OpenAI.

- WebAPI – Usa texto a voz basado en navegador.

- Silent – Solo se comunica vía texto.

- Emitir Eventos: Habilita para activar eventos de scripting.

- Observable: Activa esta opción para lanzar eventos en el mundo. Útil con nuestra API de Scripting. Ver más en la Guía del Sistema de Eventos del Agente de IA.

- Activar Proximidad: El agente detecta si un usuario entra o sale de un área definida.

- Radio de Proximidad: Define la distancia donde se activan eventos de proximidad.

- Mensajes de Usuario: Permite al agente mostrar mensajes al entrar/salir del área.

- Mensaje al Entrar: Mensaje mostrado al usuario al entrar en el radio.

- Mensaje al Salir: Mensaje mostrado al salir.

- Mensajes de Usuario: Permite al agente mostrar mensajes al entrar/salir del área.

- Radio de Proximidad: Define la distancia donde se activan eventos de proximidad.

Solo la clave API de OpenAI y el ID del modelo son obligatorios. Configura y publica tu proyecto para tener un agente funcional.

Crear un Agente de IA con OpenAI Completion

Sigue estos pasos para configurar un Agente con OpenAI Completion.

Paso 1: Crea una Cuenta en OpenAI

- Visita la Página de Registro de OpenAI y crea una cuenta.

Paso 2: Genera una Clave API de OpenAI

- Ve al Panel de OpenAI.

- Navega a la Sección de Claves API.

- Haz clic en Crear nueva clave secreta.

- Proporciona un nombre, selecciona un proyecto y establece permisos de seguridad.

- Copia y guarda tu clave API de forma segura, ya que no se mostrará de nuevo.

Una vez configurado tu asistente de OpenAI, puedes integrarlo en tu proyecto XR.

Paso 3: Integra tu Agente OpenAI con XR Creator Studio

1. Agrega un Elemento de Agente de IA en XR Creator

- Abre tu proyecto en el Editor XR.

- En el Menú de Elementos, selecciona AI Agent.

2. Configura las Propiedades del Agente de IA

En el Panel de Propiedades, puedes establecer los parámetros para conectar tu asistente.

- Nombre del Agente: Este nombre aparecerá en la interfaz de chat.

- Proveedor: Selecciona el servicio de IA, en este caso, OpenAI Completion.

- System Prompt: Instrucciones que definen el rol, personalidad o restricciones de la IA (por ejemplo, "Eres un asistente útil especializado en productos de la empresa."). Máximo ~4000 caracteres. Campo opcional.

- Memory: Define el tipo de memoria que puede utilizar tu agente de finalización. Por defecto, funciona con memoria volátil temporal, lo que significa que el agente conservará el historial del chat solo durante tu sesión. Una vez que salgas, la memoria se borrará. Alternativamente, puedes habilitar la memoria persistente, permitiendo que el agente mantenga el historial del chat a lo largo de varias sesiones.

- Clave API: Ingresa tu clave API secreta de forma segura.

- Nombre del Modelo: (Requerido para OpenAI Completion) El modelo específico de OpenAI a utilizar (por ejemplo, gpt-3.5-turbo, gpt-4, etc).

- Opciones de Voz:

- OpenAI – Usa la generación de voz de OpenAI.

- WebAPI – Usa el sistema de texto a voz del navegador (varía por navegador).

- Silencioso – El agente solo se comunicará por chat de texto.

- Emitir Eventos: Activa esta opción para que el agente desencadene eventos de scripting dentro del mundo.

- Observable (Emitir Eventos): Habilita esta opción para disparar eventos dentro del mundo. Son especialmente útiles cuando se trabaja con nuestra API de Scripting. Consulta más detalles en la guía del Sistema de Eventos del Agente de IA.

- Habilitar Proximidad: El agente puede detectar cuando un usuario entra o sale de un rango definido.

- Radio de Proximidad: Define la distancia (en metros/unidades) alrededor del agente donde se disparan eventos de proximidad (como entrada o salida del usuario).

- Prompts para Usuarios: Activa esta opción para permitir que el agente muestre mensajes personalizados cuando los usuarios entren o salgan de su proximidad.

- Prompt de Entrada: El mensaje que el agente dirá o mostrará cuando un usuario entre en el radio de proximidad.

- Prompt de Salida: El mensaje que el agente dirá o mostrará cuando un usuario salga del radio de proximidad.

- Prompts para Usuarios: Activa esta opción para permitir que el agente muestre mensajes personalizados cuando los usuarios entren o salgan de su proximidad.

- Radio de Proximidad: Define la distancia (en metros/unidades) alrededor del agente donde se disparan eventos de proximidad (como entrada o salida del usuario).

Solo la Clave API de OpenAI y el ID del Modelo no son opcionales. Una vez configuradas tus propiedades, puedes publicar tu proyecto y tener un Agente totalmente funcional.

Configurar un Agente de IA usando OpenAI Assistants

Sigue estos pasos para configurar un asistente en OpenAI y potenciar tu agente de IA en el metaverso. Este enfoque te permite cargar archivos, mejorando el conocimiento y la comprensión contextual de tu asistente.

1. Crear una Cuenta en OpenAI

- Visita la Página de Registro de OpenAI y crea una cuenta.

2. Generar una Clave API de OpenAI

- Ve al Panel de OpenAI.

- Navega a la Sección de Claves API.

- Haz clic en Crear nueva clave secreta.

- Proporciona un nombre, selecciona un proyecto y establece permisos de seguridad.

- Copia y guarda tu clave API de forma segura, ya que no se mostrará nuevamente.

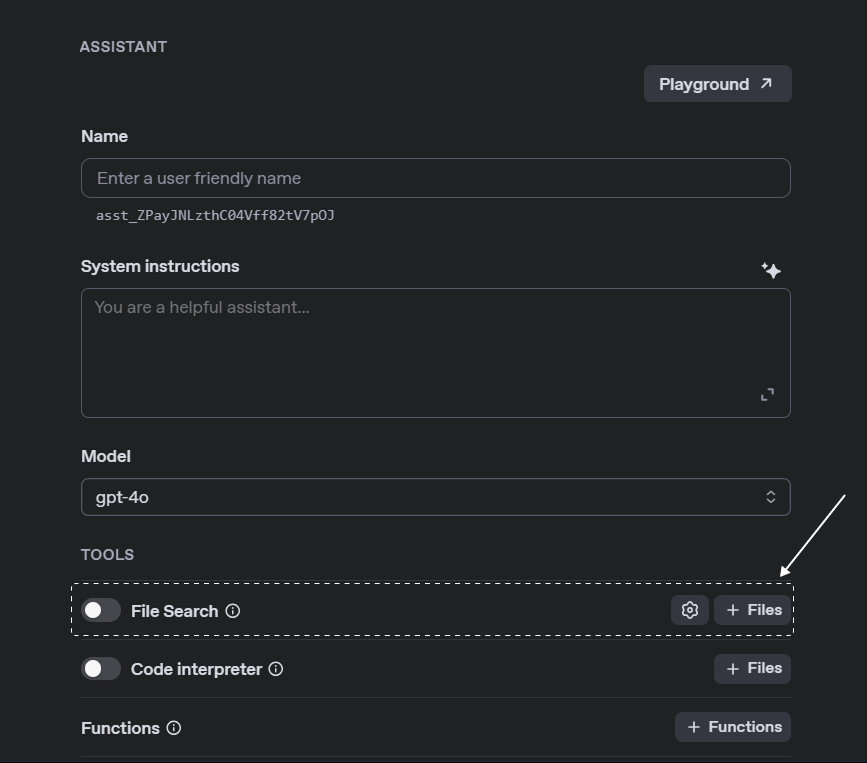

3. Crear un Asistente

- Abre la Página de Asistentes.

- Haz clic en Crear para iniciar un nuevo asistente.

- Introduce un nombre y proporciona instrucciones del sistema (hasta 256,000 caracteres).

- Carga los archivos necesarios para la base de conocimiento del asistente.

- Habilita la herramienta File Search para la recuperación de información.

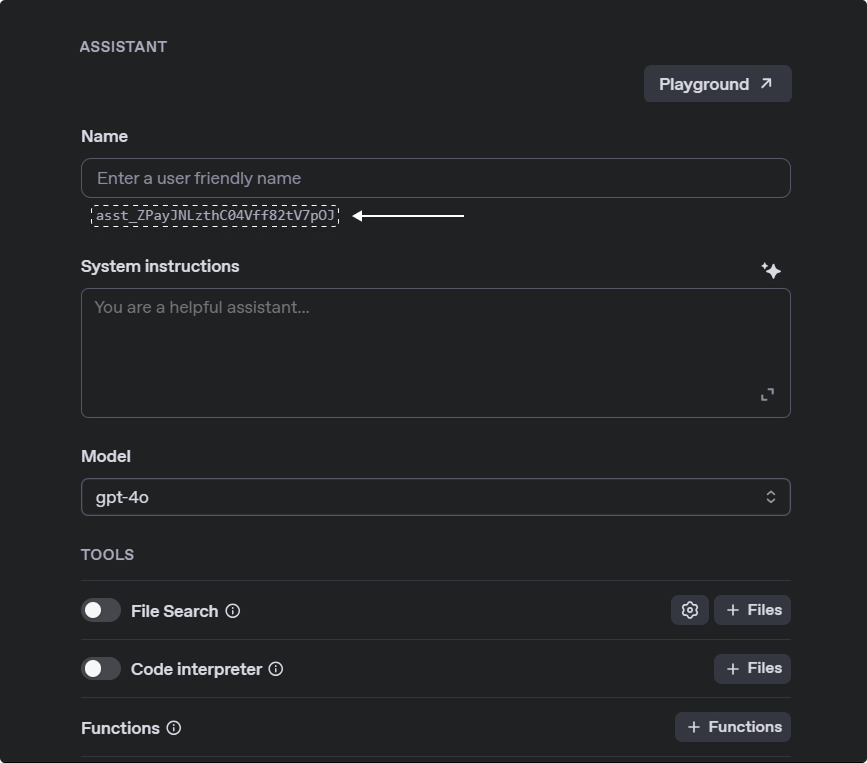

- Copia el ID del Asistente para uso futuro, lo puedes encontrar debajo del nombre de tu asistente.

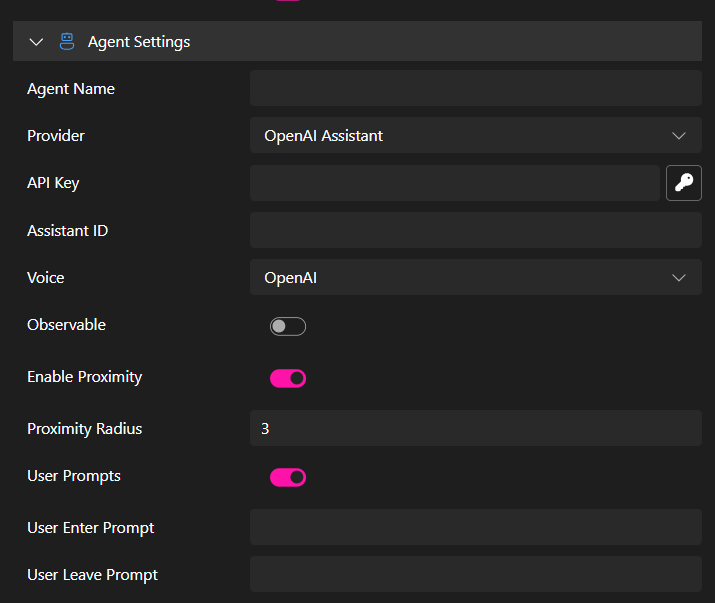

Paso 4: Integrar tu Asistente de OpenAI con XR Creator Studio

Una vez que hayas configurado un asistente de OpenAI, puedes integrarlo en tu proyecto XR.

1. Crear un Agente de IA en XR Creator

- Abre tu proyecto en el Editor XR.

- En el Menú de Elementos, selecciona AI Agent.

2. Configurar Propiedades del Agente de IA

En el Panel de Propiedades, puedes establecer parámetros para conectar tu asistente.

- Nombre del Agente: Este nombre aparecerá en la interfaz de chat.

- Proveedor: Selecciona el servicio de IA. En este caso, OpenAI Assistant.

- Clave API de OpenAI: Ingresa tu clave API secreta de manera segura.

- ID del Asistente: Identificador único (

asst_...) de OpenAI, disponible en la Página del Asistente. - Opciones de Voz:

- OpenAI – Usa la generación de voz de OpenAI.

- WebAPI – Usa texto a voz basado en navegador (varía según el navegador).

- Silencio – El agente solo se comunicará mediante chat de texto.

- Observable (Emitir Eventos): Activa esta opción para desencadenar eventos de scripting en el mundo virtual. Útil cuando se trabaja con nuestra API de Scripting. Más información en la Guía del Sistema de Eventos del Agente de IA.

- Habilitar Proximidad: El agente puede detectar cuándo un usuario entra o sale de un rango definido.

- Radio de Proximidad: Define la distancia alrededor del agente donde se activan eventos de proximidad.

- Prompts de Usuario: Activa esta opción para que el agente muestre mensajes personalizados al entrar o salir de su proximidad.

- Prompt de Entrada: Mensaje que el agente mostrará al entrar en el radio de proximidad.

- Prompt de Salida: Mensaje que el agente mostrará al salir del radio de proximidad.

- Prompts de Usuario: Activa esta opción para que el agente muestre mensajes personalizados al entrar o salir de su proximidad.

- Radio de Proximidad: Define la distancia alrededor del agente donde se activan eventos de proximidad.

Solo la Clave API de OpenAI y el ID del Asistente no son opcionales. Una vez configuradas tus propiedades, puedes publicar tu proyecto y tener un Agente completamente funcional.

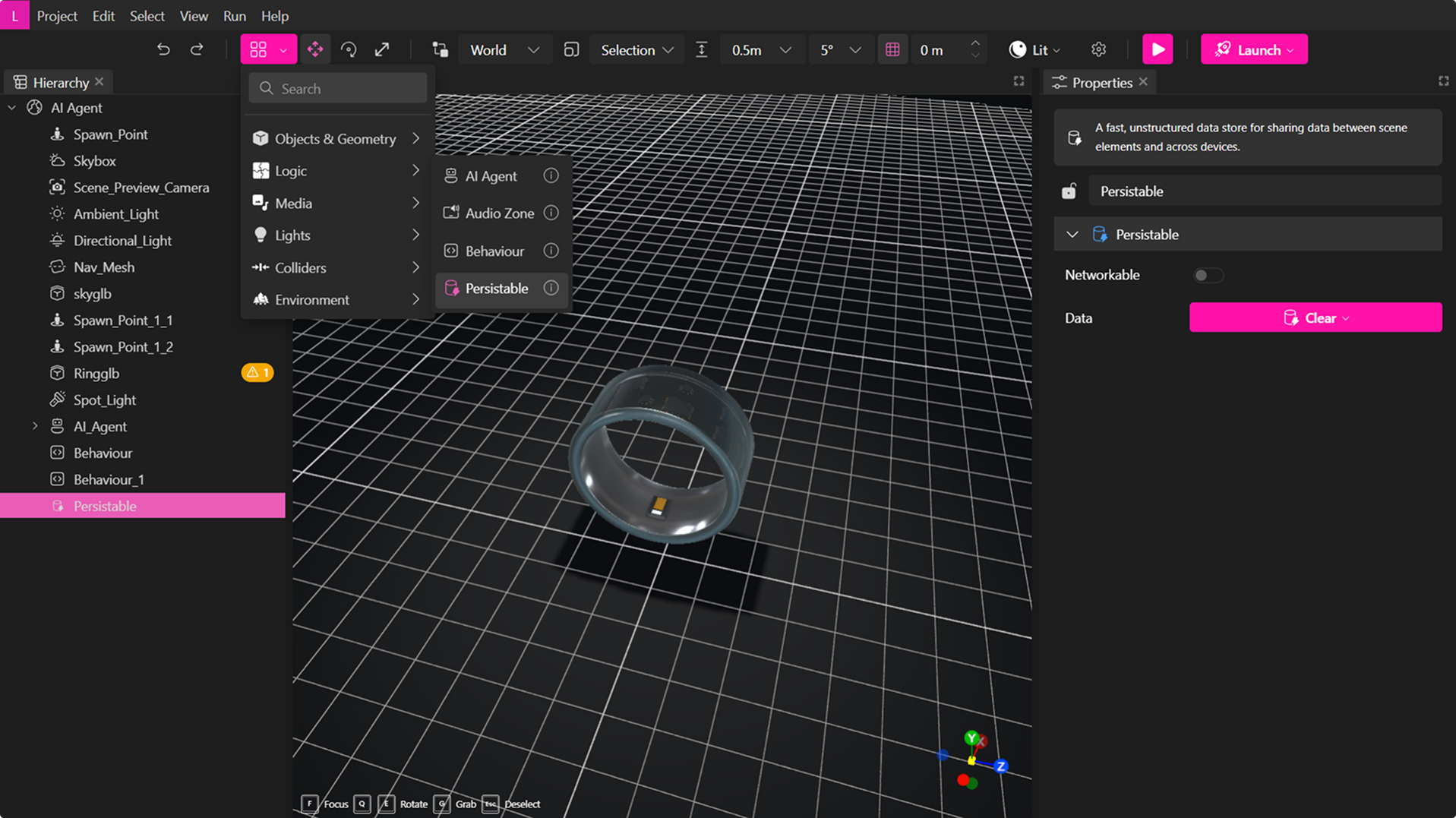

Habilitar Memoria Persistente para Agentes de Finalización

Puedes habilitar la memoria persistente para tu agente, permitiéndole conservar el historial de conversación a lo largo de las sesiones.

Para hacerlo, selecciona un elemento Persistente desde el menú desplegable de elementos, lo que lo añadirá automáticamente al panel de jerarquía.

A continuación, en las propiedades del agente, elige el elemento persistente recién creado en el menú desplegable y publica el verso.

Esto garantiza que tu agente mantenga el contexto y la memoria de la conversación a través de las sesiones.

Sistema de Eventos del Agente de IA

Cuando Emitir Eventos está habilitado, el Agente de IA puede activar varias interacciones:

| Evento | Descripción |

|---|---|

user-enter | Se activa cuando un usuario entra en la región de proximidad del agente. Solo se emite si ‘Emitir eventos’ y ‘Habilitar proximidad’ están activados. |

user-leave | Se activa cuando un usuario sale de la región de proximidad del Agente de IA. |

agent-talk-start | Se emite cuando el agente comienza a hablar. También se activa cuando inicia una secuencia de síntesis de voz. |

agent-talk-talking | Se emite durante el habla del agente en cada frame, enviando la modulación de amplitud de la onda de sonido. |

agent-talk-end | Se activa cuando el agente finaliza su discurso. |

agent-thinking | Se activa cuando el agente está procesando una respuesta, mostrando los puntos suspensivos en el chat. |

Estos eventos son especialmente útiles cuando se trabaja con nuestra API de Scripting.

Asegúrate de que Observable esté habilitado para que los eventos de scripting en el mundo se ejecuten correctamente.